Cloudera Luncurkan Layanan Inferensi AI, Didalamnya Ada Mikro NVIDIA NIM! Percepat Penerapan GenAI

Cloudera Luncurkan Layanan Inferensi AI, Didalamnya Ada Mikro NVIDIA NIM! Percepat Penerapan GenAI--

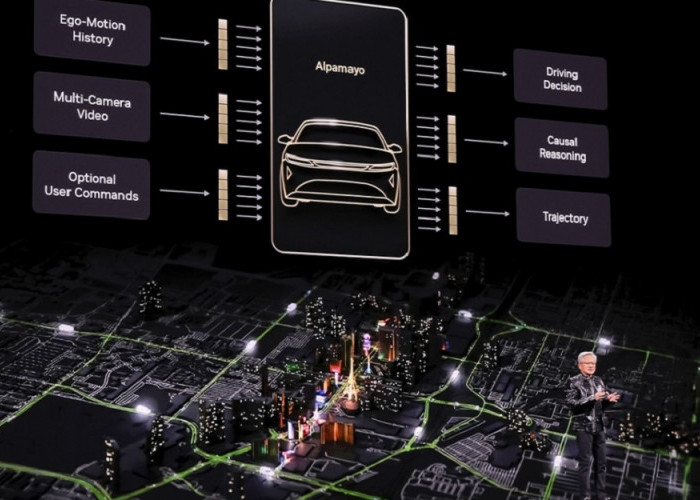

SANTA CLARA, California dan NEW YORK, Radarseluma.Disway.id, -- Cloudera , satu-satunya platform hibrida sejati untuk data, analitik, dan AI, hari ini meluncurkan Cloudera AI Inference yang didukung oleh layanan mikro NVIDIA NIM , bagian dari platform NVIDIA AI Enterprise . Sebagai salah satu layanan inferensi AI pertama di industri yang menyediakan kemampuan layanan mikro NIM tertanam, Cloudera AI Inference secara unik menyederhanakan penerapan dan pengelolaan model AI skala besar, yang memungkinkan perusahaan memanfaatkan potensi data mereka yang sebenarnya untuk memajukan GenAI dari fase uji coba ke produksi penuh.

BACA JUGA: Dengar Ya, Banner Bupati Seluma di Sekolah, Bukan Termasuk APK

BACA JUGA:Ikut Trade Expo Indonesia 2024, Bank Mandiri Ajak Wirausaha Hadapi Era Global

Data terbaru dari Deloitte mengungkapkan hambatan terbesar bagi adopsi GenAI bagi perusahaan adalah risiko kepatuhan dan masalah tata kelola, namun adopsi GenAI berkembang pesat, dengan lebih dari dua pertiga organisasi meningkatkan anggaran GenAI mereka pada Q3 tahun ini. Untuk mengurangi masalah ini, bisnis harus beralih menjalankan model dan aplikasi AI secara pribadi - baik di tempat maupun di cloud publik. Pergeseran ini memerlukan solusi yang aman dan terukur yang menghindari pendekatan yang rumit dan harus dilakukan sendiri.

Cloudera AI Inference melindungi data sensitif dari kebocoran ke layanan model AI yang dihosting vendor dan bersifat non-pribadi dengan menyediakan pengembangan dan penerapan yang aman dalam kendali perusahaan. Didukung oleh teknologi NVIDIA, layanan ini membantu membangun data tepercaya untuk AI tepercaya dengan kecepatan performa tinggi, memungkinkan pengembangan chatbot berbasis AI, asisten virtual, dan aplikasi agen yang efisien yang memengaruhi produktivitas dan pertumbuhan bisnis baru.

Peluncuran Cloudera AI Inference menyusul kolaborasi perusahaan dengan NVIDIA , yang memperkuat komitmen Cloudera untuk mendorong inovasi AI perusahaan di momen kritis, saat industri menavigasi kompleksitas transformasi digital dan integrasi AI.

Pengembang dapat membangun, menyesuaikan, dan menerapkan LLM tingkat perusahaan dengan kinerja hingga 36x lebih cepat menggunakan GPU NVIDIA Tensor Core dan throughput hampir 4x dibandingkan dengan CPU. Pengalaman pengguna yang lancar mengintegrasikan UI dan API secara langsung dengan kontainer layanan mikro NVIDIA NIM, sehingga menghilangkan kebutuhan akan antarmuka baris perintah (CLI) dan sistem pemantauan terpisah. Integrasi layanan dengan AI Model Registry milik Cloudera juga meningkatkan keamanan dan tata kelola dengan mengelola kontrol akses untuk titik akhir dan operasi model. Pengguna mendapatkan keuntungan dari platform terpadu tempat semua model—baik penerapan LLM maupun model tradisional—dikelola secara lancar di bawah satu layanan.

BACA JUGA: Penjualan Handuk Legendaris Terry Palmer Naik 40%, Inovasi Penjualan dengan Live Streaming

BACA JUGA:Daihatsu Xenia Terbaru Desain Lebih Modern dan Memikat Harga yang Terjangkau Mesin 1.3 cc

Fitur utama tambahan dari Cloudera AI Inference meliputi:

Sumber: